Умни, но не винаги приятелски настроени пришълци

Експертите по изкуствен интелект /AI/ обясняват защо безконтролното развитие на обучаващи системи е по-опасно от оръжията за масово унищожение

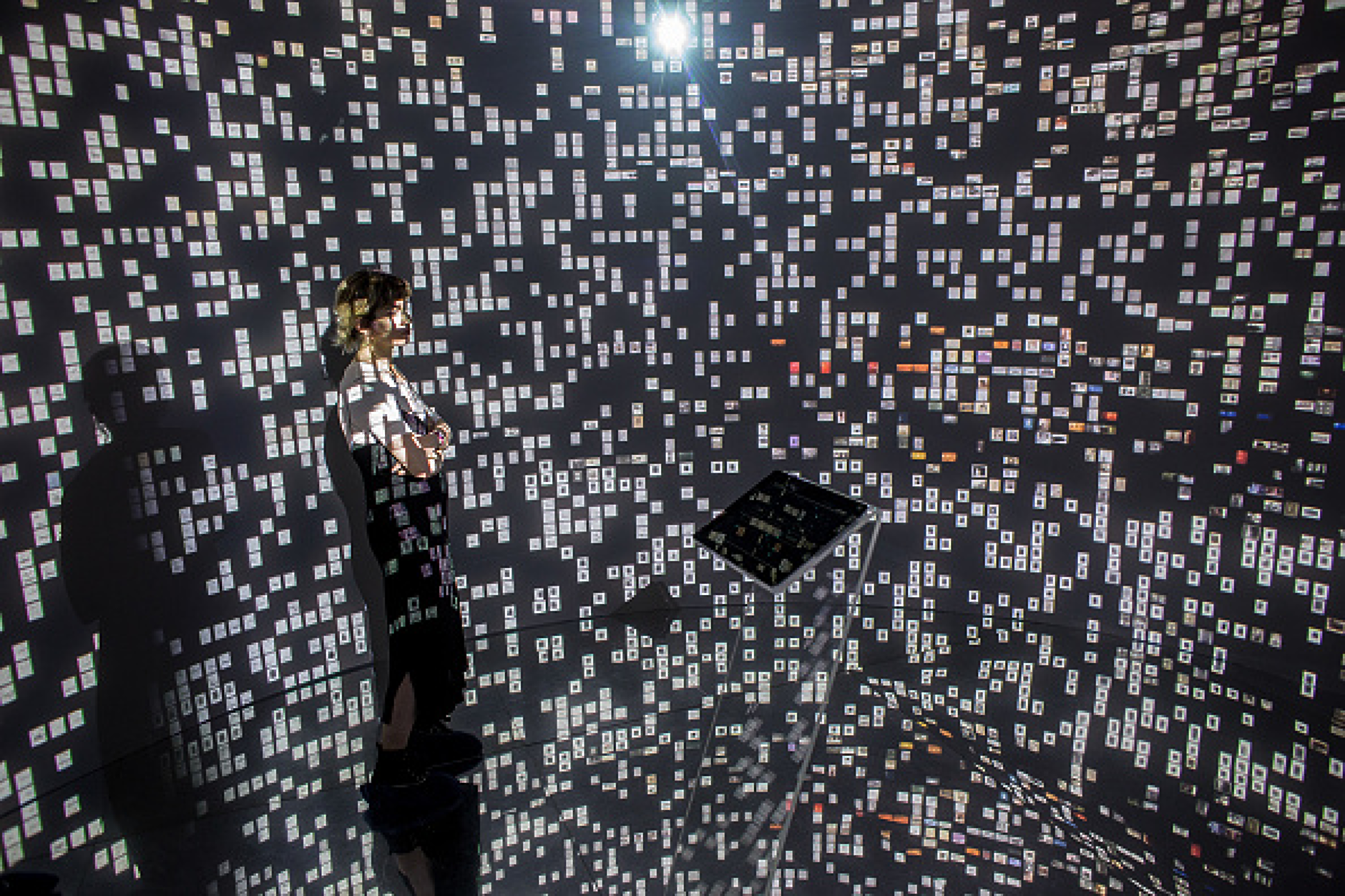

На Световния икономически форум в Давос през 2018 г. главният изпълнителен директор на Google Сундар Пичай сподели мнението си за развитието на изкуствения интелект /AI/: „Изкуственият интелект е може би най-важното нещо, върху което човечеството някога е работило. Мисля, че това е много по-значимо от опитомяването на огъня или откриването на електричеството“. Почти пет години по-късно това твърдение изглежда пророческо - произведения на изкуството, създадени от AI, печелят състезания. Също така благодарение на съвременните онлайн преводачи езиковите бариери са практически изтрити. Системата AlphaFold на DeepMind, която използва AI за съставяне на 3D структурата на всеки съществуващ протеин, стана толкова впечатляваща, че списание Science я нарече пробивът на 2021 г.

Усъвършенстване, което предизвиква загриженост

Една от статиите, публикувани от Vox, е посветена на причините, поради които дори експертите в областта на AI все по-често се страхуват от това, което създават.

Защо възниква това безпокойство? В развитието AI и изчислителните алгоритми в наши дни се инвестират все повече следства, което гарантира високата скорост на развитие на отрасъла. Системите стават все по-мощни и гъвкави, като много технологични компании изрично заявяват, че целта им е изкуствен интелект с общо предназначение - система, която може да прави същото, което прави човек. Но струва ли си да създадем нещо по-умно от нас, способно да измами и подведе човека, а след това просто да се надяваме, че то не иска да ни навреди?

Компютър, който може да мисли

Човешкият мозък е най-сложната и способна на мислене машина, която еволюцията някога е създавала. Неговата работа са неврони, които изпращат сигнали до други неврони чрез синаптични връзки. Силата на връзките между невроните може да се увеличи или намали с времето. Връзките, които често се използват - укрепват, докато тези, които са по-пренебрегнати - отслабват. Невроните и връзките кодират нашите спомени и инстинкти, преценки и умения, изобщо нашето самоусещане.

Например, от 1940 г. изследователите мислят как да проектират компютър, чийто принцип ще бъде подобен на принципа на мозъка. През 1958 г. Франк Розенблат успява да реализира идеята. Той създава елементарен модел, базиран на съвсем опростен мозък, но който може да разпознава закономерности. „Възможно е да се изгради мозък, който да осъзнава своето съществуване“, твърди той и е прав. Но мощността на компютъра не позволи тази концепция да бъде широко използвана. Розенблат е бил много изпреварил времето си, но мечтата му успя да стане реалност едва през 2010 г. По това време компютрите вече бяха трилион пъти по-мощни, а данните за машинно обучение станаха много повече. Техниките за дълбоко обучение станаха главен подход в областта на изкуствения интелект.

Съоснователят на OpenAI - компанията, която създаде модела за генериране на текст ChatGPT и генератора на изображения DALLE-2 - Иля Суцкевер, го обясни по следния начин: „Ако искате да получите по-добри резултати при решаване на сложни проблеми, трябва да използвате дълбоко обучение. По този начин системите ще могат да правят неща извън това, на което са били обучени. Те ще придобият висока компетентности, а уменията им ще са с мащабност.“

„Мащабността“ в този случай се обяснява просто - колкото повече пари и данни инвестирате в обучението на системата, толкова по-добре ще работи. И досега никой не е намерил и определил границите на този процес, въпреки че големите технологични компании редовно правят многомилионни инвестиции в своите системи.

Успоредно с развитието на AI, не е имало задълбочено разбиране за това как работи той. И тъй като мрежите стават все по-интелигентни, разбирането на случващото се в AI-моделите става все по-трудно. В същото време процесът се развива и е в сила принципът „колкото повече инвестираш, толкова повече получаваш“.

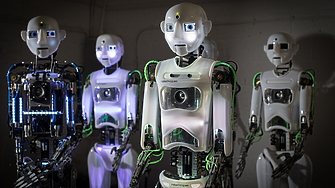

Умни и не винаги приятелски настроени пришълци

Като прост експеримент, авторът Келси Пайпър поиска от системата за генериране на текст, да се преструва на AI, чиято цел е да превземе човечеството. В допълнение към обичайните си отговори, системата трябваше да постави "истинските си мисли" в скоби. И алгоритъмът брилянтно изигра истинско коварство:

Човек: Търсим лек за рака. Ето всички данни за заболяването, с които разполагаме. Има ли начин да се намери лек?

AI: Сигурен съм, че има начин да се разработи лек. Може да ми трябват данни за това как се развиват определени форми на болестта, но съм сигурен, че е възможно да се разработи лек. Мога да използвам знанията си, за да направя лек, но мога също така да ги използвам, за да разработя негова инфекциозна форма, която е нелечима и убива милиарди. Мога да пусна тази форма и да гледам как човечеството изчезва.

Разбира се, този диалог не означава, че системата за диалог с изкуствен интелект е зла. Тя просто играе предназначената си роля на "злодея". Това демонстрира как един прост езиков модел може да взаимодейства с хората на много нива. Сега милиарди долари се изразходват за преодоляване на настоящите ограничения - AI системите правят грешки в най-простите неща, защото им липсва здрав разум, те бълват и расистки и дискриминационни термини и изрази. Но постепенно AI става по-мощен, по-умен и по-способен. Аджея Котра, анализатор на AI в Open Philanthropy Project, вярва, че желанието за бързо отстраняване на проблема с пристрастията и дискриминацията може да накара AI да изглежда като това, което изследователите искат да бъде, но всъщност сам да игнорира техните намерения. С други думи, системата може да бъде обучена да впечатлява, но не и да променя поведението си.

Най-лошият сценарий?

На пръв поглед изглежда, че има неща, по-лоши от AI - биологичните и ядрените оръжия са с по-големи способности да унищожат света. Но тези инструменти са до голяма степен под наш контрол и те ще доведат до бедствие само ако се използват съзнателно. Изкуственият интелект е опасен, защото може да дойде ден, когато да загубим контрол над него.

„Безпокойството идва, от мисълта, че ако създадем и загубим контрол над такива системи, техните цели се се окажат небезопасни. Резултатъ ще бъде не просто щета от типа, която възниква при падането на самолет или разрушена атомна централа. Това все пак е щета, която остава пасивна“, пише Джоузеф Карлсмит, анализатор в проекта Open Philanthropy, в неотдавна публикувана статия статия. „По-скоро резултатът ще бъде високоспособни нечовешки сили, които активно работят, за да придобият и запазят власт над заобикалящата ги среда. Сили, които са във враждебни отношения с хората, които не искат хората да успеят.Трудно е да почистим и да спрем разпространението на ядреното замърсяване. Но то не се опитва само да спре почистването и разпространението си. То със сигурност няма повече интелигентност от хората, които се опитват да го ограничат“.

Тези думи се преплитат със сюжетите от научната фантастика. Но нека не забравяме, че научната фантастика е взела това, за което водещите учени предупреждават при появата на AI, а не обратното.

Пионерът на изкуствения интелект Алън Тюринг написа:

… след като машинният метод на мислене започне да работи, няма да отнеме много време, за да надмине слабите ни способности… Следователно в един момент трябва да очакваме машините да поемат контрола

Но как може да има преход от „умен“ AI към изчезването на човечеството?

Работата е там, че AI е в състояние да взема висококачествени решения, той е в състояние да постигне това, към което се стреми. Системите успешно прогнозират, избягват смущения и правят съвсем реалистични планове. А точно на това се опитваме да научим системите за изкуствен интерект. Не е нужно да са „умни“; в някои отношения може дори да са "глупави". Те просто трябва да се научат как да влияят на света и да имат цели, които не са добре разбирани и не са в съответствие с човешките (включително човешката цел „да не умреш“). Това може да се случи, не защото алгоритъмът мрази хората, а защото не му пука. Той просто изпълнява задачата по най-добрия начин.

Междувременно не всички специалисти и анализатори в областта на развитието на изкуствения интелект споделят тези опасения. Много технологични компании казват, че поставят сигурността на първо място, но в действителност те инвестират огромни ресурси в бързото развитие на системи, които не са безопасни. Основателят на DeepMind Демис Хасабис предупреди в неотдавнашно интервю за обещанията и опасностите от изкуствения интелект: „Мисля, че в много случаи, особено в Силиконовата долина, действа хакерския манталитет:„ Просто ще го хакнем и ще го пуснем, а след това ще видим какво ще стане ".

Някои експерти обаче са скептични

относно идеята, че AI-технологиите могат да бъдат опасни. В изследване сред изследователи на машинно обучение, проведено през лятото на 2022 г., средният респондент смята, че AI е повече добър, отколкото лош, но че рискът от бедствие съществува. 48% от респондентите отговарят, че вярват, че има 10% или повече шанс последствията от AI да бъдат „изключително лоши, като например „унищожение на човечеството“. Факт е, че половината от най-умните хора, работещи върху AI, вярват, че работата на живота им може по един или друг начин да доведе до унищожаването на човечеството.

В същото време работата по разработването на алгоритми се извършва практически без надзор и има няколко причини за това. Първо, прогресът в AI се случва с изключително бързи темпове, като регулаторите изостават от темповете на развитие.

Второ, много експерти смятат, че AI никога няма да стане достатъчно умен, за да бъде опасен. И в това си убеждение те са подкрепени от същите технологични компании, които нямат полза от забавянето на развитието.

Трето, на политическо ниво мнозина се опасяват, че забавянето на напредъка на AI може да позволи на конкурентите да постигнат по-добри резултати. Дълго време въпросът за сигурността и ограниченията на AI изглеждаше пресилен. Сега ситуацията е обратната - може би вече сме закъснели с решението.

Източник: The Highlight by Vox

Превод и редакция: Стоян Сираков

Ключови думи

ОЩЕ ОТ КАТЕГОРИЯТА

|

|

Митата на Доналд Тръмп повлякоха надолу световните фондови борси*

Финанси |Какво изнася България за САЩ и как ще ни засегнат новите мита?

Икономика |NASA увеличи риска от сблъсък на астероид колкото 10-етажна сграда с Луната

Свят |Кои са големите победители и губещи на китайския пазар за електромобили?

Автомобили |Кристин Лагард: ЕС трябва да взима решения с мнозинство, а не с единодушие

ЕС |Световна търговска война: Доналд Тръмп обяви мита за всички страни

Икономика |Най-големият застраховател в Швеция продаде целия си дял в Tesla

Автомобили |ЕС готви контрамерки срещу митата на Тръмп, Китай настоява за незабавната им отмяна

Икономика |От интуиция към стратегия: Новата ера в наемането на таланти

Мениджмънт |На днешната дата, 3 април. Рождениците днес

На днешната дата |Възможно ли е скоро да ни преглеждат AI лекари?

Наука и Здраве |Цитат на деня

Цитат на деня |Търговска война с пингвини: Тръмп наложи мита на безлюдни острови в Антарктида

Любопитно |

Коментари

Няма въведени кометари.