Стартъпът, който иска да прави "мозъчна хирургия" на AI

Компания, наречена Goodfire, си е поставила за цел да разбере как мислят AI моделите и да ги насочи към по-добри и по-безопасни отговори. Някои от големите играчи в индустрията, като Anthropic и Menlo Venture, са инвестирали над 50 милиона щатски долара в обещаващия стартъп, пише Fast Company.

Дори когато AI става все по-тясно свързан с бизнес системите и личния живот, изследователите все още нямат ясно разбиране за това как точно моделите на AI генерират своите резултати. Досега основният метод за подобряване на поведението на AI се фокусира върху оформянето на данни за обучение и усъвършенстване на методите за подсказване, вместо да се занимава с вътрешните "мисловни" процеси на моделите. Goodfire обаче иска да насочи усилията си точно натам.

Сред съоснователите на фирмата са хора като Том Макграт, който помогна за създаването на екипа за интерпретация в DeepMind, Лий Шарки, пионер в използването на редки автокодери в езиковите модели и Ник Камарата, стартирал екипа за интерпретация в OpenAI заедно с Крис Ола. Тези изследователи могат да се похвалят с някои от най-големите открития в областта на изкуствения интелект.

Основателят и главен изпълнителен директор на Goodfire Ерик Хо, който напусна успешна компания за приложения за изкуствен интелект през 2022 г., за да се съсредоточи върху интерпретируемостта на алгоритмите, коментира, че новото финансиране ще бъде използвано за разширяване на изследователския екип и подобряване на неговата платформа за интерпретируемост Ember. В допълнение към основните си изследователски усилия, Goodfire също така генерира приходи чрез разполагане на полеви екипи, които помагат на клиентските организации да разберат и контролират резултатите от своите AI модели.

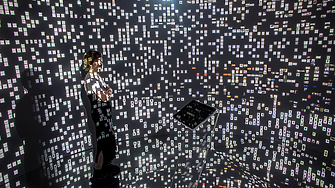

Мозъчна хирургия на AI

Goodfire разработва знанията и инструментите, необходими за извършване на т. нар. „мозъчна хирургия“ върху AI моделите. Изследователите на компанията са намерили начини да изолират модули в невронни мрежи, за да разкрият „мислите“ на AI. Използвайки техника, която наричат невронно програмиране, те могат да се намесят и да пренасочат познанието на модел към по-висококачествени и по-балансирани резултати.

„Предвиждаме бъдеще, в което можете да приложите малко инженерство към невронните мрежи“, казва Хо.

Компанията си сътрудничи с други AI лаборатории за решаване на предизвикателствата, свързани с интерпретацията. Например Goodfire помогна на Arc Institute да интерпретира вътрешната работа на неговия основен модел на ДНК Evo 2, който анализира нуклеотидни последователности и прогнозира какво следва. Разбирайки как моделът прави своите прогнози, изследователите са разкрили уникални биологични концепции с потенциален принос за нови научни открития.

Goodfire вече получава поръчки от големи компании, включително и такива от списъка Fortune 500, които искат да разберат по-добре как „мислят“ големите езикови модели, които използват за бизнеса и как да превърнат погрешните разсъждения и "халюцинациите" на AI в разумни решения. Той отбелязва, че мнозина в бизнеса все още виждат AI моделите като вид софтуер, който може да бъде препрограмиран, ако произвежда неправилни резултати. Но всъщност AI работи по различен начин: генерира отговори въз основа на вероятности и степен на случайност. Подобряването на тези резултати изисква намеса в когнитивните процеси на моделите, насочвайки ги в по-продуктивни посоки.

Този вид намеса все още е нова и неточна наука. Но Goodfire предлага първоначален набор от инструменти, който дава на бинеса ниво на контрол, по-познато от традиционния детерминистичен софтуер.

От "черна" към "стъклена" кутия

Тъй като компаниите все повече разчитат на AI за решения, които засягат реалния живот, Хо вярва, че способността за разбиране и пренасочване на "мисловните" процеси на AI алгоритмите ще бъде от съществено значение в бъдеще. Например, ако разработчик оборудва модел с етични или предпазни ограничения, организацията трябва да може да локализира слоя или параметъра в невронната мрежа, където моделът е избрал да заобиколи правилата - или се е опитал да изглежда съвместим, докато всъщност не е бил. Това би означавало да превърнете "черната кутия" на изкуствения интелект в "стъклена кутия" с инструменти, за да достигнете вътрешността и да направите необходимите настройки.

Хо е оптимист, че изследванията за интерпретируемост могат да се справят с предизвикателството.

„Това е разрешимо техническо предизвикателство, но ще са необходими нашите най-умни изследователи и инженери, за да решат наистина трудния проблем с разбирането и привеждането в съответствие на моделите с човешките цели и морал“, обяснява експертът.

Тъй като AI системите започват да надминават човешкия интелект, нарастват опасенията относно тяхното съответствие с човешките ценности и интереси. Голяма част от предизвикателството се крие в простото разбиране на това, което се случва в AI моделите, често „мислeyr“ по непрозрачен начин. Дали големите AI лаборатории инвестират достатъчно в интерпретируемостта остава открит въпрос със сериозни последици за бъдещето, управлявано от AI.

Ключови думи

ОЩЕ ОТ КАТЕГОРИЯТА

|

|

Коментари

Няма въведени кометари.