Digital Age: Сложна игра или защо учат изкуствения интелект на шах, покер и The Sims

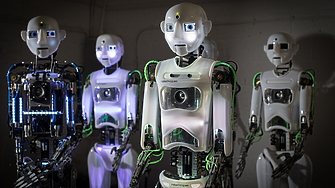

The Sims, Dota или покерът може да са нещо повече от забавление: учените използват игрите, за да обучават системите за изкуствен интелект да решават проблеми от реалния свят. Как се случва това?

В зората на развитието на изкуствения интелект учените се нуждаеха от критерии за оценка на нивото на неговото развитие. В средата на XX век, пикът на популярността на шахмата - и по-точно способността да се играе шах се превърна в показател за „интелигентността“ на технологията. Разбира се, по онова време ИИ не беше толкова мощен, за да решава шахматни задачи, затова той беше тестван върху по-прости игри и задачи, например за доказване на теореми от планиметрията.

Всяка игра е малък затворен свят със собствени правила, така че това е чудесен полигон за експерименти и проверка на свойствата на ИИ. Нека видим какви умения и как точно се обучават върху игри от различен тип.

Шах и Го

Способността да се играе шах отдавна се смята за еталон за развитието на изкуствения интелект. В края на 80-те години на миналия век за първи път стана възможно да се създаде алгоритъм, способен да се състезава с хората в тази игра: това беше шахматният суперкомпютър на IBM Deep Blue. А през 1997 г. Deep Blue успя да спечели мач срещу тогавашния световен шампион Гари Каспаров.

Шахът, както и Го (логическа настолна игра, възникнала в древен Китай), развива и тества две от най-важните свойства на системите с изкуствен интелект: предвидимост, т.е. способността да се изчисли предварително ходът на другия играч, и способността да се решават логически задачи. Тези умения са необходими и в много други приложения на ИИ - в роботиката, автоматизацията, за прогнозиране на резултатите от маркетингови стратегии и др. Например алгоритъмът MCTS, който е тестван на шах и се използва в някои шахматни двигатели, е в основата на една от системите за планиране на движенията на роботи в автоматизацията на складове. Разбира се, обучението на ИИ по шахмат има и по-тесни цели - обучение на спортисти и забавление.

Най-често системите за изкуствен интелект се обучават на базата на голям брой изиграни партии. Алгоритъмът ги анализира и след това научава повече, като играе сам със себе си.

Съществуват и системи, които се обучават от нулата, без готов материал, като например AlphaGo Zero и MuZero от DeepMind. За тази цел може да се използва методът Monte Carlo tree search, който се основава на разклонения на възможните последствия от всеки ход. Алгоритъмът „проиграва“ всяко последствие до последното, като запомня кои действия водят до успешен сценарий и кои - до отрицателен. По този начин се натрупва обширна статистика, въз основа на която изкуственият интелект взема решения в бъдещи игри.

Покер

Покерът е игра с висока степен на несигурност. Затова алгоритмите с изкуствен интелект я използват, за да се научат да вземат решения, да изчисляват рискове и да разработват успешни стратегии в условията на несигурност. В такива среди се прилагат обучени алгоритми: например ИИ може да решава проблеми, свързани с търговията с акции - да съставя инвестиционен пакет и да го управлява, без да пада под дадено ниво на възвръщаемост. Друг пример са рекламните инструменти, които избират коя реклама да се покаже на потребителя, така че той да кликне върху нея с най-голяма вероятност.

Разбира се, за да се обучат такива алгоритми, е необходима много голяма извадка от изиграни игри. Но предимството е, че в покера партиите са по-кратки, отколкото в шаха, така че не е необходимо много време за претърсване.

Предвиждането на човешкото поведение е сложна и нетривиална задача. Обикновено тя включва учене с натрупване (reinforcement learning), допълнено с евристични алгоритми (практически метод за решаване на проблеми) за оценка на действията на други играчи. При този подход агентът се научава да взема решения, като бива възнаграждаван или санкциониран за действията си, и подобрява стратегиите си въз основа на този опит. Комбинацията от учене с натрупване (reinforcement learning) и евристични алгоритми може да създаде по-адаптивен и интелигентен изкуствен интелект, който може да работи ефективно в условия на несигурност и да се справя със сложността на игрите или ситуациите с много играчи.

The Sims

През 2023 г. група изследователи от Станфордския университет и Google създават виртуален град, наречен Smallville, в играта The Sims и го населяват с 25 герои, генерирани от GPT. Героите започнали да се държат по начин, който затруднявал реалните хора да ги различават от истинските играчи.

The Sims по своя жанр е симулатор на живот. Той се използва не толкова за обучение на ИИ, колкото за оценка на способността му да имитира човешко поведение. За тази цел се използват големи езикови модели (LLM), предварително обучени върху голям брой текстове. Тези модели се срещат, например, в ChatGPT - те позволяват на алгоритъма да поддържа разговор и да отговаря на въпроси в „човешка“ формулировка.

The Sims в общи линии просто превежда текстовия диалог от LLM в действия на героите. Това е все едно да напишем на ChatGPT: „Представете си, че сте Джон Смит, работите като застрахователен агент, живеете в тази и тази къща, събуждате се в понеделник сутринта, какво ще направите?“ - и той ще отговори: „Ще си направя кафе, ще си взема душ и ще отида на работа“. И така е с всеки герой.

The Sims помага да се тества LLM в среда за комуникация с автономни агенти и да се разбере какво му липсва, преди да се потопи в реална среда. Да речем, да се разработи на негова основа гласов асистент, който ще общува по телефона с клиентите. Или да се превърне в LLM-асистент, който ще ни помага да планираме действията си, да съставяме график за деня и да решаваме ежедневни задачи. LLM се използва и в роботиката: с помощта на текстови описания един робот се научава как да извършва определени действия в различни ситуации.

StarCraft и Dota

Ако в шаха, Го и покера системата за изкуствен интелект играе за един играч, в StarCraft е необходимо да се контролират няколко единици и да се координират действията им помежду им. Задачата на ИИ тук се усложнява от тази координация на стратегиите на различните единици - условно казано, така че те да стрелят не един по друг, а по противниците си.

В реалния живот има много такива задачи. Прост пример е управлението на светофарите на дадено място. За да се намалят задръстванията, всеки светофар трябва да бъде превключен, като се вземе предвид, първо, пътната обстановка, и второ - работата на другите светофари (например, за да се пусне „зелена вълна“ за автомобилите).

StarCraft е много подобен на Dota - има и сътрудничество с агенти. Dota е по-малко специфична за много агенти, тъй като контролираме един герой - но го правим по такъв начин, че да отчитаме действията на другите играчи. Когато става въпрос за мултиплейър, ние не контролираме другите играчи, но вземаме предвид техните действия и принадлежността им към нашия или вражеския отбор. Интересно е също така, че играта е адаптирана малко за трениране на системата за изкуствен интелект, като е разработена специална опростена карта.

Doom и Minecraft

На пръв поглед Doom е обикновен шутър, в който играчът трябва да изследва места, да убива врагове и да подобрява защитата си. Но тази игра има една особеност, която я прави интересна за обучение на системи за изкуствен интелект: за разлика от всички предишни игри, в Doom играчът получава като входни данни само картина - това, което вижда пред себе си.

При шаха играчът получава описание на игралното поле, т.е. кодирана цифрова информация. В The Sims - текст, а в StarCraft и Dota - векторно описание на околната среда. С други думи, във всички случаи алгоритъмът получава вече обработена информация. В Doom обаче обучението се основава единствено на изображението: системата обработва визуална информация, запомня я и изгражда поведението си въз основа на нея.

Това свойство е добре преносимо към навигационни задачи, като например обучение на безпилотни превозни средства. Освен това средата на Doom помага да се тестват методи за вътрешна мотивация - възнаграждаване на алгоритъма за изследване на средата и придвижване по места. Това се използва и в роботиката.

Minecraft е друга популярна сред учените видеоигра в жанра "пясъчници". За разлика от други игри в нея няма ясни правила и сюжет, въображението и действията на играча са ограничени само от определени условности на света. Можете да събирате всякакви предмети, които искате, да ги използвате за добив на нови ресурси, да построите нещо и т.н. Всичко това позволява платформата да се използва като тестова среда за усъвършенствани методи за обучение чрез натрупване (reinforcement learning). Сложността на тази „вселена“ позволява на изследователите да изучават как агентът на изкуствения интелект може да се ориентира, да манипулира обекти и да взаимодейства със света. Уменията, усвоени от системите в средата на Minecraft, могат да бъдат приложени най-вече в роботиката, навигацията и вземането на решения в несигурна среда.

Бъдещето?

Всички екипи, работещи в областта на обучението с подсилване (RL), използват игри като еталон за оценка на качеството на моделите. Често тези изследователски екипи не са специализирани в конкретни игри. Изследователите дори не трябва да знаят правилата на играта или да я играят сами, тъй като се очаква агентът да научи всичко сам.

Разбира се, игровите задачи винаги са по-прости от реалните. Затвореният характер на игровия свят едновременно улеснява процеса на учене и е негово ограничение, защото играта не може да възпроизведе напълно реалния свят, в който има повече рискове и несигурност. Ето защо изследователите и разработчиците на игри създават все по-сложни симулации, които могат да поставят предизвикателства пред алгоритмите,възможно най-близки до реалния свят. Засега обаче решаването на сложни проблеми в реалния свят все още изисква човешко участие.

Ключови думи

ОЩЕ ОТ КАТЕГОРИЯТА

|

|

Коментари

Няма въведени кометари.