Digital age: 5-те най-големи заплахи за сигурността, които могат да бъдат причинени от изкуствения интелект

Големите езикови модели и ботовете, които ги използват, като ChatGPT, разпалиха дебат миналата година за заплахите, породени от генеративния изкуствен интелект. През 2024 г. ще има още по-голямо внимание към борбата с тези явления. Но дали експертите и потребителите обръщат внимание на реалните рискове?

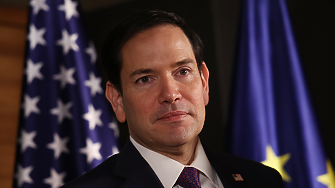

Докато бумът на изкуствения интелект продължава, залозите за киберсигурност се повишават през новата година с президентските избори в САЩ през ноември, продължаващия недостиг на умения в сектора на киберсигурността и нарастването на заплахите от още по-умен зловреден софтуер, които отново тревожат професионалистите в областта на информационната сигурност.

Ето петте потенциално най-опасни заплахи, които могат да бъдат подсилени от възхода на генеративния изкуствен интелект.

1. Дийпфейкс

Изследователите отдавна описват дълбоките фалшификати (deepfakes или дийпфейкс) като най-тревожното използване на изкуствения интелект за престъпления, но това ново поколение дигитални медии все още не са изпълнили прогнозите им. Във всеки случай все още не.

През последните месеци обаче страховете им започнаха да се сбъдват. Според проучване на Onfido, онлайн компания за проверка на самоличността, базирана в Лондон, опитите за измами с дълбоки фалшификати ще нараснат с невъобразимите 3000%.

Дълбоките фалшификати вече се появяват и при по-обикновени измами. Най-забележителният пример беше открит през октомври 2023 г., когато в TikTok се появи видеоклип, който твърдеше, че показва прочутия YouTube потребител MrBeast, предлагащ нови iPhone-и само за 2 долара. Тогава американецът с истинско име Джеймс Доналдсън възропта срещу невъзможността на социалните медии да се справят с възхода на тези нови заплахи.

Въпреки това финансовите измами, при които се използват убедителни дълбоки фалшификати, остават рядкост. Досега са известни само три, но се очаква броят им бързо да се увеличи. Тъй като дълбоките фалшификати стават все по-усъвършенствани, по-достъпни и по-евтини, техният мащаб може бързо да се разшири. Това явление все още не е масовизирано за щастие, но ще се превърне в проблем в много кратък срок.

За да се намали рискът, някои експерти по киберсигурност предлагат една старомодна защита: безопасни думи.

Представете си видеоразговор с колеги или членове на семейството. Ако някой поиска чувствителна информация, например паричен превод или поверителен документ, отговорете с искане да ви каже паролага - ваша "безопасна дума", която предварително сте уточнили, преди да изпълните искането. Може би в момента звучи малко нелепо, но въпреки това трябва да го правим, защото в бъдеще ще бъде все по-трудно да се различава реалното от манипулираното съдържание. Създаването на безопасна дума точно сега е много евтина застраховка срещу това, когато това започне да се случва в голям мащаб през 2024 г. и след това.

2. Дълбоки измами

Въпреки че по име приличат на дълбоки фалшификати, дълбоките измами не включват непременно манипулирани медии. В техния случай "дълбока" се отнася до огромния мащаб на измамата. Той се постига чрез автоматизация, която може да разшири целите на атаката от една шепа до безкрайно много хора.

Техниката може да даде тласък на всички видове измами. Инвестиционни измами, фишинг измами, имотни измами, измами с билети, романтични измами... навсякъде, където има ръчна работа, има място за автоматизация.

Преди време нашумя случаят с измамника от Тinder, който открадна приблизително 10 млн. долара от жени, с които се бе запознал онлайн. Представете си, че той е имал достъп до големи езикови модели (LLM), за да разпространява лъжите си, генератори на изображения, за да добавя привидни фотографски доказателства, и езикови конвертори, за да превежда съобщенията си. Потенциалните жертви щяха да бъдат огромен брой.

Така благодарение на лесно достъпните алгоритми бихте могли да измамите едновременно 10 000 жертви, вместо три или четири.

Измамниците в Airbnb също могат да се възползват от предимствата. Понастоящем те обикновено използват откраднати изображения от истински обяви, за да убедят туристите да направят резервация. Това е трудоемък процес, който може да бъде осуетен с обратно търсене на изображения. С генеративния изкуствен интелект тези пречки вече не съществуват. Благодарение на Stable Diffusion, DALL-E и Midjourney можете просто да генерирате неограничено количество напълно правдоподобни оферти в Airbnb, които никой няма да може да открие.

3. Малуер, захранван от големи езикови модели

Изкуственият интелект вече пише зловреден софтуер. Открити са поне три червея, които стартират LLM, за да пренаписват кода всеки път, когато зловредният софтуер се репликира. Нито един от тях все още не е открит в реални мрежи, но те са публикувани в популярната софтуерна платформа GitHub - и работят.

Базирани на програмен интерфейс на OpenAI, червеите използват GPT, за да генерират различен код за всяка заразена цел. Това ги прави трудни за откриване. OpenAI обаче може да включи поведението на зловредния софтуер в черен списък. Това е възможно да се направи с най-мощните системи за генериращ изкуствен интелект за писане на код, тъй като те са със затворен код.

Ако обаче можете да изтеглите целия голям езиков модел, тогава бихте могли да го стартирате локално или на свой собствен сървър и компаниите вече не биха могли да ви включат в черния списък. Това е предимството на генеративните системи за изкуствен интелект със затворен код.

Това предимство се отнася и за алгоритмите за генериране на изображения. Предложете свободен достъп до кода и наблюдавайте как ограниченията за насилие, порнография и измама се премахват. Като се има предвид това, не е изненадващо, че OpenAI е по-затворена, отколкото подсказва името на компанията.

4. Откриване на експлойти от типа 0-day

Друга надигаща се тревога е свързана с експлойтите от типа "нулев ден", които се откриват от нападателите, преди разработчиците да са създали решение на проблема. Изкуственият интелект може да открива тези заплахи - но може и да ги създава.

Чудесно е, когато можете да използвате асистент с изкуствен интелект, за да открие нулеви дни в кода ви, така че да можете да ги поправите. И е ужасно, когато някой друг използва ИИ, за да намери нулеви дни в кода ви, така че да може да ви експлоатира. Все още не сме стигнали точно дотам, но мнозина експерти вярват, че това ще стане реалност - и то вероятно в краткосрочен план.

Студент, работещ в компанията за киберсигурност WithSecure, вече е демонстрирал заплахата. В рамките на дипломно задание той получава редовни потребителски права за достъп до командния ред на компютър с Windows 11. След това студентът напълно автоматизирал процеса на сканиране за уязвимости, за да стане местен администратор. WithSecure реши да засекрети дипломната работа, защото не смята, че е отговорно да публикуваме изследването, което може да попадне в лоши ръце.

5. Автоматизиран зловреден софтуер

От десетилетия насам големите компании за киберсигурност включват автоматизацията в своите защити. Това им дава предимство пред нападателите, които все още до голяма степен разчитат на ръчни операции. За престъпниците има ясен начин да преодолеят разликата: напълно автоматизирани кампании за зловреден софтуер.

Това би превърнало играта в сблъсък "добър изкуствен интелект срещу лош изкуствен интелект".

И тази игра ще започне скоро. Когато това стане, резултатите могат да бъдат тревожни. Толкова обезпокоителни, че наблюдатели определят напълно автоматизирания зловреден софтуер като заплаха номер едно за сигурността през 2024 г. Но зад ъгъла се крие още по-голяма заплаха.

Теорията, известна като Закон на Хиппонен по името на прочутия финландски специалист по киберсигурност Мико Хиппонен, гласи, че всеки уред, който е описан като "умен", е уязвим. Ако този закон се приложи към свръхинтелигентните машини, може да си навлечем сериозни неприятности.

Не е необходимо да си с прекалено развинтено научно-фантастично въображение, за да предположим, че се очаква да станем свидетели на въздействието от този закон в близко бъдеще. Това би добавило спешност към страховете за изкуствения общ интелект. За да се запази човешкият контрол върху общия ИИ, трябва да вървим в посока на силно съгласуване с нашите цели и нужди. Нещата, които изграждаме, трябва да имат разбиране за човечеството и да споделят дългосрочните си интереси с хората. Предимствата от технологичната революция са огромни - по-големи от всичко досега - но и недостатъците са по-големи от всичко досега.

Ключови думи

ОЩЕ ОТ КАТЕГОРИЯТА

|

|

Коментари

Няма въведени кометари.